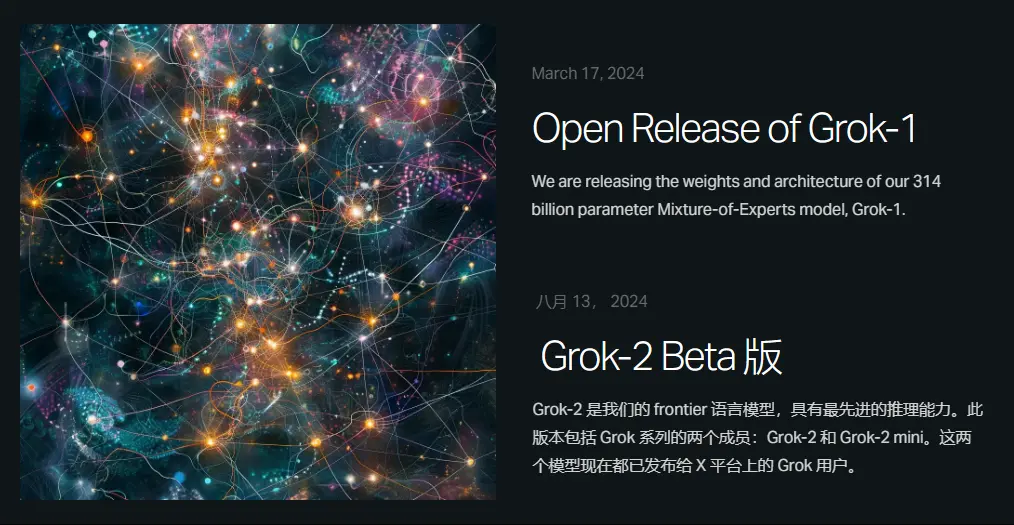

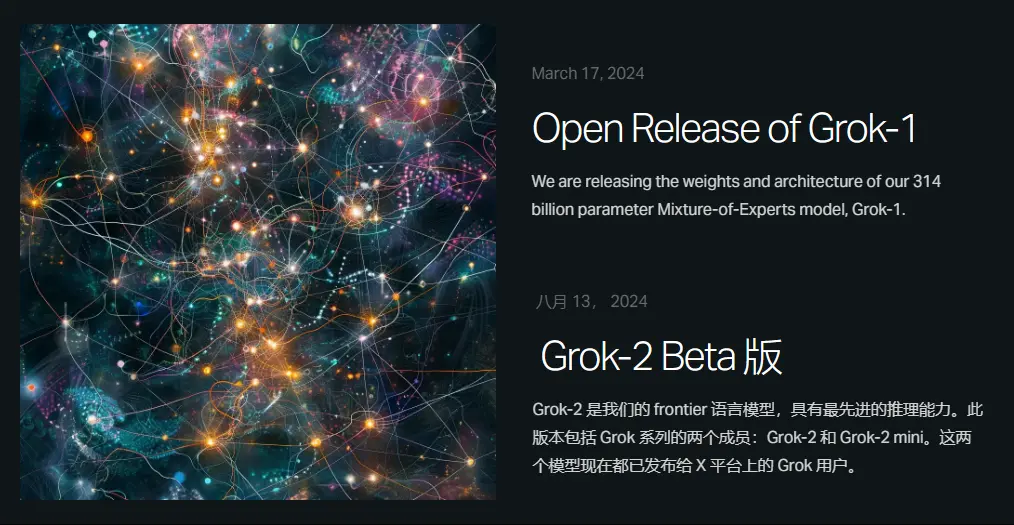

马斯克发布Grok-1模型:3140亿参数全面开源

Grok-1 和 Grok-2 的对比:

- Grok-1:有 3140 亿参数的 Mixture-of-Experts(混合专家)模型,其中 25% 参数激活在给定 token 上。它是一个基础模型,未针对特定任务微调,只进行大规模文本预训练,适用于通用的自然语言理解任务。

- Grok-2:是更先进的版本,具有更强的推理和对话能力。它在 LMSYS 排行榜上表现优异,甚至超越了 Claude 3.5 和 GPT-4-Turbo。还包含一个小型版本 Grok-2 mini,便于资源受限环境使用。

Grok-1 语言模型简介

马斯克的xAI公司开源了全球最大的大语言模型Grok-1,参数量达3140亿。Grok-1采用混合专家架构,激活权重为25%,2023年10月自定义训练完成。模型的主要特点包括64层Transformer、旋转嵌入、131,072的词汇大小和8192 tokens上下文长度,显示出在推理和编码任务中的卓越性能。尽管表现出色,但仍存在生成幻觉及搜索功能不足的局限。Grok-1开源遵循Apache 2.0许可证。

Grok-1 模型磁力下载

磁力链接下载Grok-1 GitHub 官方下载

前往 GitHub 下载租赁 H100 云 GPU 搭建 Grok-1

前往 Vultr 租赁调用HuggingFace Hub

pip install huggingface_hub[hf_transfer]

huggingface-cli download xai-org/grok-1 –repo-type model –include ckpt-0/* –local-dir checkpoints –local-dir-use-symlinks False

模型详情

Grok-1是一个庞大的开源语言模型,具有3140亿个参数,采用混合专家架构(MoE),激活权重为25%。它基于丰富的文本数据进行训练,未进行特定任务的微调。模型包含64层Transformer,使用旋转嵌入,并支持8192个token的上下文长度,精度为bf16。

模型能力

在标准测试中表现优异,HumanEval编码任务得分63.2%,MMLU得分73%,并在数学考试中获得C级(59%)。

局限性

模型缺乏独立搜索能力,可能会产生错误信息,需结合人工审查和工具使用。

开源意义

遵循Apache 2.0许可证,支持用户自由使用和修改,体现了xAI的透明化与开放理念,为未来研究提供宝贵资源。

总之,Grok-1是一个值得关注的开源语言模型,实际应用中需注意结合其他工具以发挥最佳效果。

📌 版权声明

本网站分享的 软件资源、补丁、注册机及相关注册信息 仅限于 学习和研究 目的,请勿用于商业或非法用途,否则由用户自行承担一切后果。

本站 原创内容(包括 摄影作品、后期教程、软件研发 等)受著作权保护,未经授权 禁止转载或商业使用。

若本站内容侵犯您的权益,请通过电子邮件联系我们,我们会及时处理。感谢您的理解与支持!

📌 Copyright Notice

The software resources, patches, keygens, and registration information shared on this website are for educational and research purposes only. Any commercial or illegal use is strictly prohibited, and users shall bear all consequences.

Original content on this site, including photography, post-production tutorials, and software development, is protected by copyright law. Unauthorized reproduction or commercial use is strictly prohibited.

If this content infringes on your rights, please contact us via email, and we will address the issue promptly. Thank you for your understanding and support!

⚠️ 免责声明

站内部分软件资源来源于网络,仅用于学习交流,不得用于任何商业或非法用途。

请在下载后的 24 小时内,彻底删除相关内容。

如果您喜欢该程序,请 支持正版软件,购买注册并享受官方服务。